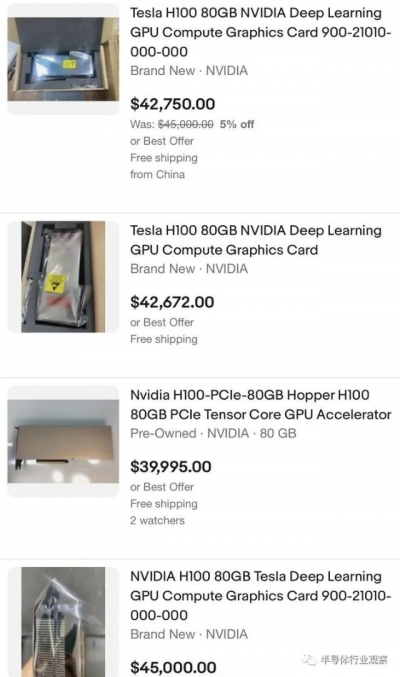

據外媒CNBC報道,隨着對訓練和部署人工智能軟件所需芯片需求的飆升,英偉達的最先進的顯卡在eBay上的售價超過 40,000 美元。

3D 遊戲先驅和前Meta咨詢技術主管約翰卡馬克在 Twitter 上注意到 Nvidia H100 處理器的價格。周五,eBay 上至少有 8 台 H100 掛牌,價格從 39,995 美元到略低於 46,000 美元不等。過去一些零售商的售價約爲36,000 美元。

去年發布的 H100 是 Nvidia 最新的旗艦 AI 芯片,它是 A100 的繼任者,A100 是一款價值約 10,000 美元的芯片,被稱爲 AI 應用的“主力軍”。

开發人員正在使用 H100 構建所謂的大型語言模型 (LLM),這是 OpenAI 的 ChatGPT 等人工智能應用程序的核心。運行這些系統非常昂貴,並且需要強大的計算機一次處理數 TB 的數據數天或數周。他們還依賴強大的計算能力,因此人工智能模型可以生成文本、圖像或預測。

訓練 AI 模型,尤其是像 GPT 這樣的大型模型,需要數百個高端 Nvidia GPU 協同工作。例如微軟就斥資數億美元購买了數萬顆 Nvidia A100 芯片,幫助打造 ChatGPT。Nvidia 控制着 AI 芯片的絕大部分市場。

Nvidia 還提供了一台帶有八個 GPU 的超級計算機,稱爲 DGX。今年早些時候,該公司宣布推出新服務,允許公司以每月 37,000 美元的價格租用 DGX 計算機。以這個價格,該系統將使用 Nvidia 的舊 A100 處理器。

Nvidia 表示,H100 是第一款針對特定 AI 架構進行優化的芯片,該架構支撐着 AI 的許多最新進展,稱爲 transformers。行業專家表示,要構建比目前可用的模型更大、數據需求量更大的模型,將需要更強大的芯片。

ChatGPT引爆算力需求

今年以來,ChatGPT的火爆已經席卷了全球,而這火爆背後就需要GPU的強力支持。

早在2020年五月,微軟就披露,公司已經建造了世界上公开披露的前五名超級計算機之一,在 Azure 中提供新的基礎設施來訓練超大型人工智能模型。“托管在 Azure 中的超級計算機與 OpenAI 合作並專爲OpenAI構建,專爲訓練該公司的 AI 模型而設計。”微軟強調。

據當時的文章介紹,爲 OpenAI 开發的超級計算機是一個單一系統,具有超過 285,000 個 CPU 內核、10,000 個 GPU 和每個 GPU 服務器每秒 400 GB 的網絡連接。微軟表示,與全球TOP500超級計算機上的其他機器相比,它名列前五。托管在 Azure 中的超級計算機還受益於強大的現代雲基礎設施的所有功能,包括快速部署、可持續數據中心和對 Azure 服務的訪問。

到了今年三月,微軟又在另外一篇文章中進行了更多的披露。

微軟負責战略合作夥伴關系的高級主管Phil Waymouth強調,OpenAI 訓練其模型所需的雲計算基礎設施的規模是前所未有的——網絡 GPU 集群的規模呈指數級增長,超過了業內任何人試圖構建的規模。

爲了滿足對更復雜和更大模型的日益增長的需求,微軟宣布了新的功能強大且可大規模擴展的虛擬機,這些虛擬機集成了最新的 NVIDIA H100 Tensor Core GPU 和 NVIDIA Quantum-2 InfiniBand 網絡。虛擬機是 Microsoft 向客戶提供基礎設施的方式,可以根據任何 AI 任務的規模進行擴展。據微軟稱,Azure 的新 ND H100 v5 虛擬機爲 AI 开發人員提供了卓越的性能和跨數千個 GPU 的擴展。

微軟 Azure 高性能計算和人工智能產品負責人 Nidhi Chappell說,這些突破的關鍵是學習如何構建、操作和維護數萬個在高量、低延遲 InfiniBand 網絡上相互連接的共置 GPU。她解釋說,這個規模甚至比 GPU 和網絡設備供應商測試過的還要大。這是一片未知的領域。沒有人確切知道硬件是否可以在不損壞的情況下被推到那么遠。

她解釋說,爲了訓練一個大型語言模型,計算工作量被分配到一個集群中的數千個 GPU 上。在此計算的某些階段(稱爲 allreduce),GPU 會交換有關它們已完成工作的信息。InfiniBand 網絡加速了這一階段,該階段必須在 GPU 开始下一個計算塊之前完成。

“因爲這些工作涉及數千個 GPU,所以你需要確保擁有可靠的基礎設施,然後你需要在後端擁有網絡,這樣你才能更快地溝通,並能夠連續幾周這樣做,”Chappell 說。“這不是代表這你只需購买一大堆 GPU,將它們連接在一起就可以开始協同工作的東西。爲了獲得最佳性能,需要進行大量系統級優化,這需要幾代人積累的豐富經驗。”

龐大的算力要求的背後,必然是GPU需求的急升和成本的增加。

根據semianalysis在今年二月的一篇文章中披露,ChatGPT 每天在計算硬件成本方面的運營成本爲 694,444 美元。OpenAI 需要約 3,617 台 HGX A100 服務器(28,936 個 GPU)來爲 Chat GPT 提供服務,估計每次查詢的成本爲 0.36 美分。

但是,ChatGPT僅僅是一個开始。

大模型浪潮需要更多的GPU

在ChatGPT爆火之後,谷歌Bard迅速發布,微軟和亞馬遜等巨頭也不甘人後。在國內,巨頭也紛紛湧入,初創公司也迅速崛起。就連在早前呼籲暫停人工智能研發的Elon Musk也开始加入了大模型的混战。

據報道,在聘請了幾位前 DeepMind 研究人員一個多月後,Twitter 正在推進一個內部人工智能項目。Business Insider則透露,Elon Musk 最近購买了 10,000 個 GPU,用於公司剩余的兩個數據中心之一。據報道,該項目涉及創建一個生成式人工智能,該公司將根據自己的海量數據進行訓練。

與此同時,據金融時報報道,Elon Musk還計劃成立一家新的AI公司,與OpenAI競爭。

據熟悉這位科技企業家計劃的人士透露,特斯拉和 Twitter 的負責人正在組建一個由人工智能研究人員和工程師組成的團隊。

據一位直接了解談判情況的人士透露,馬斯克還在與 SpaceX 和特斯拉的一些投資者討論將資金投入他的新企業的事宜。“一群人正在投資它。. . 這是真實的,他們對此很興奮,”該人士說。

據知情人士透露,對於新項目,馬斯克已經從 Nvidia 獲得了數千個高性能 GPU 處理器。GPU 是 Musk 建立大型語言模型的目標所需的高端芯片——人工智能系統能夠攝取大量內容並產生類似人類的文字或逼真的圖像,類似於爲 ChatGPT 提供支持的技術。

而在在本周的 Twitter Spaces 採訪中,馬斯克被問及 Business Insider 的一份報告,該報告稱 Twitter 購买了多達 10,000 個 Nvidia GPU,“似乎每個人和他們的狗此時都在購买 GPU,”( “It seems like everyone and their dog is buying GPUs at this point”)馬斯克說。“Twitter 和特斯拉肯定會購买 GPU。

這引爆的GPU需求顯而易見。

據《財經十一人》在三月份的報道,截止當時,微軟的Azure雲服務爲ChatGPT構建了超過1萬枚英偉達A100 GPU芯片的AI計算集群。多位雲計算技術人士對《財經十一人》表示,運行ChatGPT至少需要1萬枚英偉達的A100芯片。然而,GPU芯片持有量超過1萬枚的企業不超過5家。其中,擁有1萬枚英偉達A100 GPU的企業至多只有1家。

TrendForce集邦咨詢則表示,由於生成式AI必須投入巨量數據進行訓練,爲縮短訓練就得採用大量高效能GPU。以ChatGPT背後的GPT模型爲例,其訓練參數從2018年約1.2億個到2020年已暴增至近1800億個,TrendForce集邦咨詢預估GPU需求量約2萬顆,未來邁向商用將上看3萬顆(計算基礎以NVIDIA A100爲主)。

而英偉達成爲背後幾乎的唯一GPU贏家,H100則成爲了大家爭奪的新目標。

計算力暴漲的H100是救星

在算力需求劇增下,英偉達的GPU幾乎成爲了唯一的硬通貨,而去年年初發布,並在九月量產的H100最新、最強的救星。

作爲一個專爲專注於 AI 功能的超級計算機而設計的產品。與當前的 A100 相比,H100包括了大量更新和升級,所有設計均達到新的性能和效率水平。Hopper 包含 800 億個晶體管,它是使用定制的 TSMC 4N 工藝制造的。值得一提的是,這是一個針對 Nvidia而優化的4nm工藝,不要將其與 TSMC 也提供的通用 N4 4nm 工藝混淆。作爲對比,A100 GPU“僅”有 540 億個晶體管。

H100 支持 Nvidia 第四代 NVLink 接口,可提供高達 900 GB/s 的帶寬。對於不使用 NVLink 的系統,它還支持 PCIe 5.0,最高可達 128 GB/s。更新的 NVLink 連接提供比 A100 多 1.5 倍的帶寬,而 PCIe 5.0 提供的帶寬是 PCIe 4.0 的兩倍。

H100 還將默認支持 80GB 的 HBM3 內存,帶寬爲 3 TB/s——比 A100 的 HBM2E 快 1.5 倍。雖然 A100 有 40GB 和 80GB 兩種型號,後者在生命周期的後期出現,但 H100 和 A100 仍然使用多達六個 HBM 堆棧,顯然禁用了一個堆棧(即使用虛擬堆棧)。一般來說,H100 的內存和接口帶寬比其前身多 50%。

可以肯定的是,這是一個很好的改進,但 Hopper 的其他方面涉及更大的改進。

H100 可以提供高達 2,000 TFLOPS 的 FP16 計算和 1,000 TFLOPS 的 TF32 計算,以及 60 TFLOPS 的通用 FP64 計算——這在所有三種情況下都是 A100 性能的三倍。Hopper 還增加了改進的 FP8 支持,計算能力高達 4,000 TFLOPS,比 A100 快六倍(A100 由於缺乏原生 FP8 支持而不得不依賴 FP16)。爲了幫助優化性能,Nvidia 還有一個新的transformer引擎,可以根據工作負載自動在 FP8 和 FP16 格式之間切換。

Nvidia 還將添加旨在加速動態編程的新 DPX 指令。這些可以幫助廣泛的算法,包括路线優化和基因組學,Nvidia 聲稱這些算法的性能比上一代 GPU 快 7 倍,比基於 CPU 的算法快 40 倍。Hopper 還包括改進安全性的更改,多實例 GPU (MIG) 現在允許在單個 H100 GPU 上運行七個安全租戶。

所有這些變化對於 Nvidia 的超級計算和 AI 目標都很重要。然而,這些變化並不都是爲了更好。盡管轉移到更小的制造節點,但 SXM 變體的 H100 TDP 已增加到 700W,而 A100 SXM 模塊爲 400W。這是 75% 以上的功率,根據工作負載,改進範圍似乎在 50% 到 500% 之間。總的來說,我們預計性能將比 Nvidia A100 快兩到三倍,因此效率應該仍有淨提升,但這進一步證明了摩爾定律正在放緩。

總體而言,Nvidia 聲稱 H100 的擴展性優於 A100,並且可以在 AI 訓練中提供高達 9 倍的量。它還使用 Megatron 530B 量作爲基准,提供 16 到 30 倍的推理性能。最後,在 3D FFT(快速傅立葉變換)和基因組測序等 HPC 應用程序中,Nvidia 表示 H100 比 A100 快 7 倍。

寫在最後

其實從去年下半年开始,因爲行業的下行,英偉達的數據中心業務一直下滑,公司市值也不僅是腰斬。但隨着ChatGPT的火熱,英偉達又逆風翻盤,上漲了超過80%。從最早的顯卡,到AI加速,到挖礦,再到現在的ChatGPT,英偉達正在抓住一波又一波的機遇。

英偉達CEO黃仁勳則表示:“世界對數據中心的需求量將會增長。這對世界來說是一個真正的問題。我們應該做的第一件事是:世界上的每個數據中心,無論你決定做什么,爲了可持續計算的好處,盡你所能加速。”

“我們現在有 700 多家客戶在嘗試,從汽車行業到物流倉庫再到風力渦輪機工廠,”黃仁勳說。“它可能代表了英偉達所有技術中最偉大的容器:計算機圖形學、人工智能、機器人技術和物理模擬,集於一身。我對它寄予厚望。”

過去幾十年的技術積累和开拓是黃仁勳說出這樣的話的底氣。

本文作者可以追加內容哦 !

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播信息之目的,不構成任何投資建議,如有侵權行為,請第一時間聯絡我們修改或刪除,多謝。

標題:英偉達H100市面價格飆升!ElonMusk:每個人都在买GPU

地址:https://www.breakthing.com/post/53027.html