導語:混元大語言模型,從理論上可以打破騰訊的原有的產品版圖邊界,讓AI連接起各個產品與用戶之間的需求。

目前,中國大模型領域的競爭,已經進入一個群雄逐鹿的亂战時代。

截止4月上旬,國內已有多家頭部企業發布/或預發布了自己的大模型,其中包括了:

1、 $百度集團-SW(HK|09888)$的文心一言

2、華爲的大模型盤古

3、$阿裏巴巴-SW(HK|09988)$的大模型通義千問

4、$商湯-W(HK|00020)$科技的日日新大模型

5、騰訊(HK:00700)的混元大模型

一時間,“尋找或成爲中國的OpenAI”,成爲了國內各企業最首要的問題。

雖然科技創新講究的就是一個“快”字,但“快”也不是一味的。

如何在保證速度的同時,解決好資金、算力、數據、人才,以及更多未知的工程化方法,都是一個頗爲考驗“內功”的環節。

目前,互聯網行業中的一些企業,已經在大模型領域展現出了自己的實力,比如阿裏這類領軍企業,但同時,還有像騰訊這樣實力不容小覷的企業尚未發力。

騰訊作爲互聯網行業的領軍企業之一,擁有強大的技術實力、豐富的數據積累以及AI基礎設置,讓其在AIGC領域的布局備受關注。

萬億大模型

自OpenAI發布Chatgpt以來,大模型領域一個明顯的趨勢,就是隨着算力的發展,模型容量持續提升,模型通用性和泛化能力也更強。

然而,此前國內基於萬億大模型的應用探索極少,在高速網絡、訓練/推理框架、模型算法和落地應用等方面,也沒有全面深入的公开性研究。

在這種情況下,作爲頭部企業之一的騰訊,自然動了欲作开拓者的野心。

然而,若要問鼎“萬億大模型”這枚王冠,強大的算力則是必不可少的。於是,騰訊設計的一套“先蒸餾後加速”的大模型壓縮方案——太極-HCF ToolKit,就應運而生了。

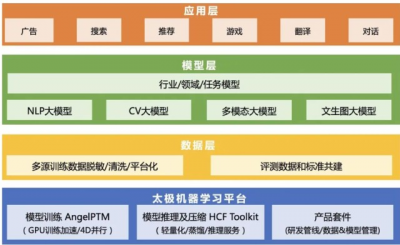

太極平台,包含了從模型蒸餾、壓縮量化到模型加速的完整能力,爲AI工程師打造從數據預處理、模型訓練、模型評估到模型服務的全流程高效开發工具。

由於太極框架封裝了很多功能和驗證,因此只要配置正確,就不需要再進行額外的測試。這大大加快了开放的進度。

以太極平台的基礎,配合強大的底層算力與低成本的高速網絡基礎設施,騰訊打造了首個可在工業界海量業務場景直接落地,並投入應用的萬億NLP大模型——HunYuan-NLP 1T(以下簡稱混元)。

混元最快僅用256卡在一天內即可完成萬億參數大模型的訓練,整體訓練成本僅爲直接冷啓動訓練萬億模型的1/8。

而騰訊之所以在訓練成本上如此大費周章,則與其自身的战略布局有着密切的關系。

縱觀混元在騰訊應用層、模型層的布局,我們可以發現,這樣的布局策略,很有可能是想以統一的平台,實現技術復用和業務降本,支持更多的場景和應用。

而這樣的技術復用和多場景支持,則與騰訊在互聯網領域獨特的生態位有着密切關系。

騰訊目前已有的互聯網江山,涵蓋了社交、遊戲、廣告、內容創作等多個領域,如何用最低的成本,爲原先已有的衆多產品和業務進行賦能和升級,就成了騰訊在AI時代首先要考慮的問題。

目前,騰訊已經打造了以混元 AI 大模型爲技術底座的廣告多媒體 AI 技術矩陣;以及應用於創作的智能創作助手;和通用遊戲競技 的AI“絕藝”+“絕悟”。

可以說,這種通過降低模型訓練成本,從而迅速讓AIGC 技術爲多個領域賦能的做法,與互聯網行業發展初期,很多企業通過“燒錢”的方式,以迅速擴大市場份額的策略,着實有一種“異曲同工之妙”。

AIGC時代的新“微信”

“混元”對騰訊 AI 應用生態的拓展,絕不僅僅是一次對原有業務的“縱向升級”。

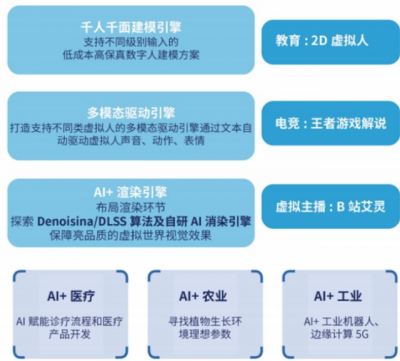

從某種程度上說,這樣的生態的拓展,體現了騰訊在人工智能時代,對社會各領域、各產業層面的新一輪商業滲透的展开。

而這種多元化布局的思路,可以說是對其在移動互聯網時代“攻城略地”的一次復刻。

在移動互聯網時代,騰訊的野心就已經四溢到了遊戲、社交、金融、廣告等多個領域。這種多元化的業務布局,使得騰訊的觸手深入到了網絡生活的各個方面,並最終通過微信這個終端,一步步整合了人們對於衣食住行的大部分需求,以至於到了人們難以對其脫離的地步。

在當下的社會中,人們幾乎無法想象沒有微信的生活會是怎樣的。

在進行多元化布局的同時,通過“燒錢”的方式不斷投資並購,也是騰訊壯大自身的另一大手段。

如京東、美團、滴滴等,這些企業都是行業內的領先者,與騰訊的業務有很強的互補性,能夠爲騰訊帶來更多的商業機會和收益來源,從而進一步擴大了騰訊自身的業務版圖。

然而,隨着互聯網紅利消失, 市場已經進入相對平穩的發展階段,各大巨頭們也开啓了從增量到存量的战爭。

在這樣的背景下,傳統的“花錢买量”已經難以再帶來新的用戶增長,既然原有產品的“縱向增量”已經走到盡頭,那么通過跨領域融合的“橫向增量”方式,繼續維持或擴大自身龐大的業務版圖,就成了騰訊若要在AIGC時代,一種最可行的策略。

憑借已有的龐大的用戶數據,加上大模型帶來的开放平台、生態合作,將自身的業務逐漸與農業、醫療、工業、教育等領域融合,可以最終編織成一張深深嵌入社會各個領域的智能化網絡。

正如移動互聯網時代,微信通過二維碼、朋友圈、小程序等功能的推出,不斷擴寬了自身的應用場景,並實現了用戶數的一次次飛躍。

在人工智能時代,通過混元大模型帶來的通用+專用領域的融合功能,意味着騰訊能夠將各個領域的數據和信息進行整合和分析,混元大模型可以提供更加個性化、智能和高效的服務,從而進一步增強用戶的忠誠度和粘性。

而當這些來自多個領域的信息、數據,最終被大模型整合進某一終端時,一個涵蓋了人們各個不同領域需求的“AIGC版微信”,或許也就此誕生了。

在某種程度上,它可能會比現在的微信更“必要”、更“難以離身”,得益於大語言模型知識抓取、邏輯分析能力,一些涉及事項多、專業性強,並且與民衆需求緊密相連的需求(如醫療、法律等領域),最後甚至僅僅能通過人們一句簡單的“命令”,得到實現。

如此一來,混元大語言模型,從理論上可以打破騰訊的原有的產品版圖邊界,讓AI連接起各個產品與用戶之間的需求。

算力的邊界

若要支撐起這樣橫跨各領域、多業務的大模型生態,一道繞不過去的坎,就是算力的限制。

盡管大模型概念持續火熱,但入局者大多面臨着算力之困。

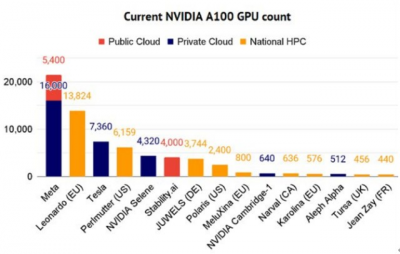

市場上流傳的調研紀要顯示,要訓練像ChatGPT這樣的生成式AI,至少需要1萬張英偉達A100加速卡的支持。目前,國內只有6家公司具備這樣的硬件實力。

然而,這樣的“算力邊界”,並沒能阻止騰訊在AIGC時代擴充自身版圖的野心。

4月14日,騰訊雲正式發布了面向大模型訓練的新一代高性能計算集群HCCPNV5。

該集群採用最新一代騰訊雲星星海自研服務器,並搭載了英偉達 H800 Tensor Core GPU(國內首發),提供業界目前最高的3.2Tbps超高互聯帶寬,算力性能比前代提升了3倍。

H800 Tensor Core GPU

一般來說,一個集群的性能,主要取決於三個要素:單機算力、網絡架構、存儲性能。

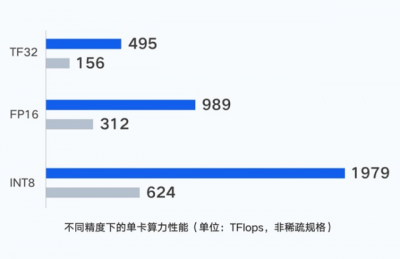

在單卡單機的算力上,新一代集群單GPU卡支持輸出最高495 TFlops(TF32)、989 TFlops (FP16/BF16)、1979 TFlops(FP8)的算力,單卡性能爆表。

而得益於騰訊雲星星海服務器採用6U超高密度設計,每節點支持8塊H800,上架密度與同行相比提升了30%。利用並行計算理念,通過CPU和GPU節點的一體化設計,將單點算力性能提升至最強。

然而,僅僅有了先進的芯片,並不等於擁有先進算力。

原因在於高性能計算存在“木桶效應”,一旦計算、存儲、網絡任一環節出現瓶頸,就會導致運算速度嚴重下降。

因此,先進算力的背後是先進芯片、先進網絡、先進存儲等一系列的支撐,缺一不可。

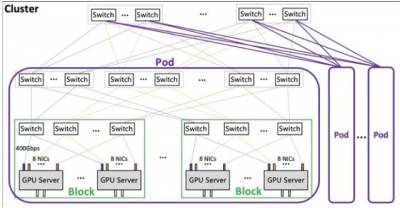

此次騰訊自研的星脈網絡,爲新一代集群帶來3.2T的超高通信帶寬。在「星脈網絡」的加持下,單集群規模支持4K GPU(最大支持10萬+ GPU)、超EFLOPS(FP16)算力。

搭載同樣的GPU卡,3.2T星脈網絡相較前代網絡,能讓集群整體算力提升20%,使得超大算力集群仍然能保持優質的通信开銷比和性能。並提供單集群高達十萬卡級別的組網規模。

最後的存儲問題,在大模型訓練場景下,存儲也經受着前所未有的考驗。

幾千台計算節點會同時讀取一批數據集,需要盡可能地縮短數據集的加載時長。

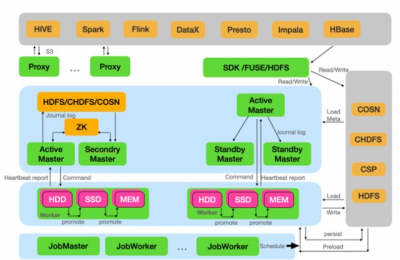

而新一代HCC集群,引入了騰訊雲最新自研存儲架構,支持不同場景下對存儲的需求。

例如其中的COS+GooseFS方案,就提供基於對象存儲的多層緩存加速,大幅提升了端到端的數據讀取性能;

而CFS Turbo多級文件存儲方案,則充分滿足了大模型場景下,大數據量、高帶寬、低延時的存儲要求。

如此一來,算力、網絡、存儲,三個關鍵的節點,都被騰訊一一攻克了。

隨着新一代HCC高性能計算集群的發布,國內大模型訓練面臨的算力困局有望得到紓緩,而國內的人工智能生態,也有可能從此走向百花齊放的局面。

這是因爲,雖然對於中國企業來說,雖然ChatGPT這樣大模型,工作量和成本並不是不可接受,但只有在算力、算法、數據等不同環節,讓衆多公司構成了一個龐大的人工智能生態,量變引起質變,中國自己的世界級大模型,才會有“湧現”的基礎。

說到底,ChatGPT不是OpenAI一家公司的成功,而是一種人工智能生態的成功。

隨着混元大模型所帶來的低成本訓練紅利,國內大模型多元化格局也有望就此形成,而由此構建出的人工智能生態,也將有望讓ChatGPT這類AI發生在中國、根植在中國。#全球AI監管潮來襲,行情將如何演繹?#

本文作者可以追加內容哦 !

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播信息之目的,不構成任何投資建議,如有侵權行為,請第一時間聯絡我們修改或刪除,多謝。

標題:探營騰訊混元大模型

地址:https://www.breakthing.com/post/53572.html