內容轉自品玩GenAI,已獲公衆號授權轉載,如有侵權請聯系刪除。

昨夜,老黃在 SIGGRAPH 2023 的主題演講上透露了英偉達爲降低生成式AI使用門檻所做的最新努力。

在發布會上還發生了一件“小插曲”,老黃不小心將自己的指紋粘在了全新的GPU上,爲現場的觀衆道歉。

生成式AI是這次大會毋庸置疑的絕對主角,黃仁勳會上透露的在軟件和硬件以及生態方面的更新,歸結起來就是盡力降低生成式AI的使用門檻——促進大模型的真正落地。

“买的越多,省的越多”2.0

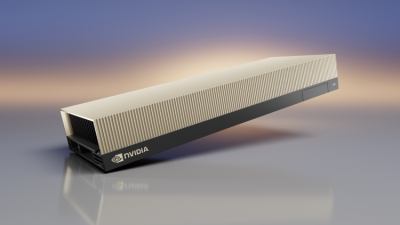

硬件方面,英偉達推出了GH200超級芯片的更新版,或者可以叫它HBM3E增強版。它是世界第一款HBM3e 處理器。

通過英偉達NVLink技術,彼此互聯的Grace Hopper超級芯片平台能夠提供1.2TB的快速內存,由於HBM3e 內存比當前 HBM3 快 50%,平台總共能提供 10TB/秒的組合帶寬。也就是說,其內存容量增加3.5倍,帶寬增加了3倍,平台包括了一台具有144 個 Arm Neoverse 核心、8 petaflops 的 AI 性能和 282GB 最新 HBM3e 內存技術的服務器。它同時與早先在台北電腦展上公布的英偉達MGX服務器規範完全兼容。

數據中心的硬件正在快速向加速計算轉變,這是黃仁勳一直在強調的一個趨勢。相比CPU,GPU在能效上有很大的優勢,黃仁勳演講中舉的例子是同樣1億美元成本,相比x86架構CPU,GH200將能提供超過20倍能效提升。

於是我們又聽到了黃仁勳那句名言:the more you buy, the more you save. 买的越多,省的越多。

可以說也是不忘初心了。

黃仁勳現場展示的PPT顯示,2500張GH200組成的數據中心相比CPU有20倍能效優勢。

除了數據中心外,黃仁勳還發布了兩套硬件,它們同樣針對大模型而來。

一款是桌面級的RTX工作站,包括最多四個RTX 6000 Ada GPU,單個桌面工作站可提供高達5,828 tflops的AI性能和192GB GPU內存。

另一款是 OVX服務器,其中包括了8個英偉達L40S GPU,每個 GPU 配備 48GB 內存,可提供超過 1.45 petaflops 的張量處理能力。

作爲對比,新的RTX工作站運行8.6億個token的GPT3-40B需要15個小時,OVX服務器則只需要7小時。實際上,OVX服務器相比A100,推理性能提高了1.2倍,訓練性能上提高1.7倍。其單精度浮點 (FP32) 性能是 A100 的近 5 倍。

英偉達L40S GPU

這些硬件的更新是有梯度的,黃仁勳演講中也點的很明白:for everyone,英偉達在每個價格階段上都爲潛在客戶准備了對應產品。

因此除了服務器和工作站之外,英偉達還同時發布了三款專業顯卡——RTX 5000, RTX 4500 and RTX 4000,它們採用了Ada Lovelace 架構,在顯存方面都有提升(RTX 4000有 20GB GDDR6顯存;RTX 4500 爲24GB;RTX 5000 最高爲32GB ),這是英偉達顯卡過去曾一度削弱的部分,而現在顯存對於大模型來說無比重要。另外它們還使用了第四代Tensor Core,AI 訓練性能比上一代快了兩倍,並擴展了對 FP8 數據格式的支持。

這些硬件最終組成了一個矩陣,囊括了從企業級客戶到個人用戶。但在黃仁勳看來,想要觸達每一個人,英偉達還需要一些“軟工具”。

軟硬兼施

距離黃仁勳推出 DGX Cloud 才短短幾個月,英偉達在降低用戶和开發者使用大模型門檻方面又有新的動作。

其中一項是非常好猜的,那就是和 Hugging Face 的合作。在此之前,Hugging Face 已經和包括 AMD 亞馬遜雲等在內的諸多巨頭緊密合作,大家都看中了它集成开放模型的優勢,英偉達也不例外。

“點擊一下鼠標即可實現英偉達AI計算。”黃仁勳說,幾個月前發布的DGX Cloud 和Hugging Face 平台集成到了一起。用戶可以先在自己的電腦上啓動項目,然後擴展到工作站和數據中心。

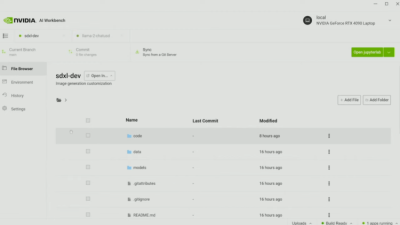

另一項名叫英偉達AI Workbench,开發人員可以直接在PC和工作站上創建、測試和定制預訓大模型。這非常像國內的大模型預訓練平台,把模型、框架和軟件开發套件與庫集合到了一個統一的开發人員工具包中,要說區別那就是AI Workbench能直接調用英偉達的算力資源,並且更好的支持英偉達的硬件——前面發布的那些工作站和服務器不用說都支持AI Workbench的本地測試和微調。

开發者原本需要分散在各處的大模型开發工具與流程,現在由英偉達AI Workbench整合了起來。

它的界面就是一個網站。截圖可以看到,本地計算機使用的是消費級 4090 移動版顯卡。

這極大簡化了大模型的操作流程,實際上你只需要一台電腦就夠了。

“每個人都可以做到這一點。”黃仁勳說道,某種意義上講,這像是大模型的民主化。

另外一個旨在降低生成式AI部署門檻的服務是名爲AI Enterprise 4.0的企業軟件平台,主要針對企業客戶。AI Enterprise 4.0包括了名爲NeMo的大模型雲原生框架和集群管理軟件,幫助企業客戶管理從雲到數據中心再到邊緣設備的所有AI解決方案,它會被集成到谷歌雲和微軟的Azure。

場景在哪裏

大模型最近一個頗爲引人爭論的話題是,它的場景到底在哪裏?

這對善於從第一性原理出發的老黃來說恐怕完全不是問題,一方面有硬件技術,一方面有軟實力。英偉達的層次顯然更高一點——不是找尋場景,而是打造生態。因爲在英偉達看來,恐怕沒有什么所謂“垂直場景”,一切都可以被生成式AI介入,承載它的是Omniverse。

元宇宙在黃仁勳這裏不是一個過氣的名詞,而是連接虛擬與物理世界,並且極大开發生成式AI潛力的工具。在虛擬與現實的轉換中,英偉達看中了名爲Universal Scene Description,通用場景描述(簡稱OpenUSD)的潛力。

黃仁勳把OpenUSD對虛擬世界的重要性與HTML之於2D互聯網的重要性相提並論。簡單來說,你可以把OpenUSD理解成一套通用的描述3D場景的語言——這在過去往往需要非常復雜的流程和不同的工具才能實現。

有了這種通用語言,不同的人能基於同樣的背景建構3D世界——也就是元宇宙的世界。

通過OpenUSD構建共同的3D場景——盡管來自不同的工具和平台。

顯而易見,OpenUSD在英偉達的元宇宙愿景中佔有重要地位,爲此,Omniverse進行了多重升級。

一方面,黃仁勳推出了四個Omniverse Cloud API,方便开發人員無縫地實施和部署 OpenUSD 應用。

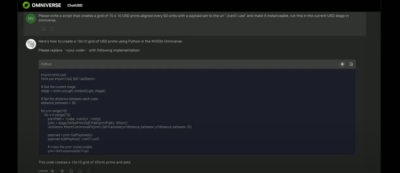

最吸引人的是一個名爲ChatUSD的功能,顧名思義,它能通過問答形式幫助开發者生成3D模型,現場演示的例子中,你提出要求,ChatUSD可以直接給你提供Python-USD 代碼腳本——直接使用它們就可以了!

另外使用了生成式AI技術的API名爲DeepSearch,它是一個大語言代理(LLM agent),可以快速搜索無標記數據庫的內容。

另一方面,Omniverse本身進行了大升級以更好支持OpenUSD,比如用少量的編碼就能快速开發本機 OpenUSD 應用以及允許用戶組建基於OpenUSD的大規模場景。

在英偉達看來,Omniverse 將因爲OpenUSD而增強,它可以跨3D工具和應用進行對世界的虛擬,這意味着一種生態的搭建:既然大家都是用OpenUSD進行3D世界的建構,那么顯然,數字孿生所需要的互聯、互相操作可以以此爲基礎實現。

由此,英偉達的元宇宙生態——它被生成式AI和OpenUSD所加持——變得初具規模,Adobe Firefly可以作爲 Omniverse 中的 API 提供給开發者,而許多業界知名的元宇宙和虛擬人开發者,Convai、Inworld AI和Wonder Dynamics都能夠借助OpenUSD的通用標准與Omniverse實現連接。

英偉達對元宇宙的未來充滿自信。波士頓動力正在使用Omniverse來模擬機器人交互,更多的工業自動化案例,包括沃爾沃、奔馳和寶馬都是Omniverse的客戶——在實際投入巨資建設一個昂貴的工廠之前,它們在Omniverse的虛擬世界裏檢查和測試物理世界的方方面面。

步入融合

生成式AI熱度不退,英偉達當然更有理由爲其添一把柴,老黃是個盡職盡責的商人,發布會上他說的最後一句話還是 the more you buy, the more you save. 足見其不忘初心的商人本色。

而想要讓自己的硬件賣的更好,股價再創新高,英偉達一面需要不斷迭代產品,提升性能,打造更豐富的生成式AI產品矩陣,另外一方面還要進一步降低大模型的使用門檻——後者甚至只有英偉達才能做到,它踩中了一個絕佳的點位,圖形。

爲了讓機器生成圖像,人類花了幾十年時間,最終英偉達开發出了顯示卡,而現在的事實證明,適用於圖形顯示的並行計算恰好也適用於生成式AI,而虛擬世界也需要更強大的圖形技術和人工智能的幫助。

黃仁勳在演講剛开始的時候就舉了個例子:來自全球最大廣告公司WPP的藝術家通過Omniverse運用多種支持OpenUSD的工具創建了比亞迪汽車的數字孿生版本——全球100多個地區的營銷活動基於這些生成內容。

五年前的SIGGRAPH大會,英偉達發布了支持光线追蹤的GPU,那時恐怕沒有人會想到,人工智能,虛擬世界,加速計算,雲,它們會以如此迅猛的速度逐漸融合爲一體。

本文作者可以追加內容哦 !

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播信息之目的,不構成任何投資建議,如有侵權行為,請第一時間聯絡我們修改或刪除,多謝。

標題:史上最糟糕發布會!黃仁勳爲指紋沾上GPU道歉

地址:https://www.breakthing.com/post/87371.html