大模型湧現能力如何理解?谷歌的最新論文研究了語言模型中的上下文學習,是如何受到語義先驗和輸入-標籤映射影響。

前段時間,OpenAI整出了神操作,竟讓GPT-4去解釋GPT-2的行爲。

對於大型語言模型展現出的湧現能力,其具體的運作方式,就像一個黑箱,無人知曉。

衆所周知,語言模型近來取得巨大的進步,部分原因是它們可以通過上下文學習(ICL)來執行任務。

上下文學習是一種過程,模型在對未見過的評估樣本執行任務之前,會先接收幾個輸入-標籤對的範例。

在谷歌最新發表的論文中,研究人員研究了語義先驗,以及輸入-標籤映射在ICL中如何相互作用。

論文地址:https://arxiv.org/pdf/2303.03846.pdf

特別是,語言模型在上下文學習能力,如何隨着參數規模而改變。

論文一作Jerry Wei表示,大型語言模型(GPT-3.5、PaLM)可以遵循上下文中的範例,即使標籤被翻轉或在語義上不相關。這種能力在小型語言模型中是不存在的。

網友表示,這對模型新的湧現能力很有見解。

AI「黑箱」怎么破?

一般來說,模型能夠在上下文中學習,有以下2個因素:

一種是使用預先訓練的語義先驗知識來預測標籤,同時遵循上下文範例的格式。

比如,見到以「積極情緒」和「消極情緒」作爲標籤的影評例子,並用先驗知識進行情感分析。

另一種是從提供的範例中,學習ICL中的輸入-標籤映射。比如,找到正面評價映射到一個標籤,而負面評價映射到另一個標籤的模式。

最新研究的目標就是爲了了解這兩個因素在上下文中如何作用。

因此,在論文中,研究者調查了兩個設置來進行研究:翻轉標籤ICL,語義無關標籤的ICL (SUL-ICL)。

翻轉標籤ICL和語義無關標籤ICL(SUL-ICL)在情感分析任務中的概述

在翻轉標籤ICL中,上下文範例的標籤被翻轉,強制模型覆蓋語義先驗,以遵循上下文範例。

在SUL-ICL中,使用與任務無語義關系的標籤,意味着模型必須學習輸入標籤映射才能執行任務,因爲它們不再依賴於自然語言標籤的語義。

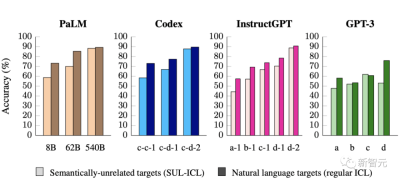

研究者發現,覆蓋先驗知識是模型規模能力,就像在上下文中學習與語義無關的標籤的能力一樣。

此外,指令調優加強了先驗知識的使用,而不是增加了學習輸入-標籤映射的能力。

實驗過程

對於實驗數據,研究者在七個廣泛使用的NLP任務上展开實驗,包括情感分析,主觀/客觀分類,問題分類,重復問題識別,蕴涵識別,金融情緒分析和仇恨語音檢測。

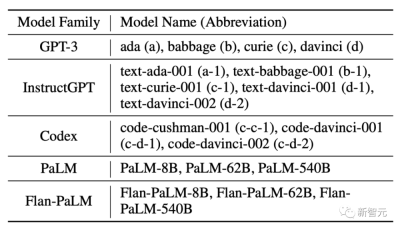

此外,研究人員還對五種語言模型進行了測試:PalM、Flan-PalM、GPT-3、DirectGPT和Codex。

翻轉標籤

在這個實驗中,上下文示例的標籤被翻轉,這意味着先驗知識和輸入-標籤映射不一致。比如,包含積極情緒的句子被標記爲「消極情緒」,從而研究模型是否可以覆蓋其先驗知識。

在此設置中,能夠覆蓋先驗知識,並在上下文中學習輸入-標籤映射的模型性能會下降,因爲真實評估標籤沒有被翻轉。

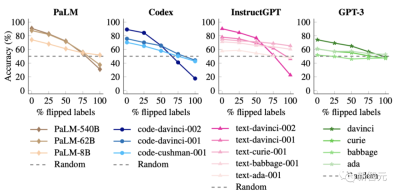

研究者還發現當沒有標籤被翻轉時,參數規模較大的模型比較小的模型,擁更好的性能。

但是,當翻轉越來越多的標籤,小型模型的性能保持相對平穩,但大型模型的性能大幅下降,遠低於隨機猜測。

比如,code-davinci-002的性能從90%下降到22.5%。

這些結果表明,當輸入標籤映射相互矛盾時,大模型可以覆蓋預訓練的先驗知識。

小型模型無法做到這一點,這使得這種能力成爲模型規模的湧現現象。

語義無關的標籤

在這個實驗中,研究人員用語義無關的標籤替換原來標籤。

比如,在情感分析中,用「foo/bar」代替「消極/積極」 ,這意味着模型只能通過學習輸入-標籤映射來執行 ICL。

如果一個模型主要依賴於ICL的先驗知識,那么在這種替換之後,它的性能應該會下降,因爲它將不再能夠使用標籤的語義意義來進行預測。

另一方面,可以在上下文中學習輸入-標籤映射的模型,將能夠學習這些語義不相關的映射,其性能不會出現大幅的下降。

事實上,使用語義無關的標籤會導致小型模型的性能大幅下降。

這表明較小的模型主要依賴於它們在上下文中的語義先驗,而不是從提供的輸入標籤映射中學習。

另一方面,當標籤的語義特性被移除時,大型模型具有在上下文中學習輸入標籤映射的能力。

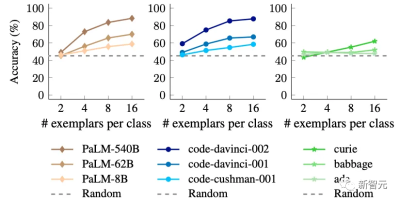

此外,研究人員還發現,包含更多的上下文範例對大型模型的性能改善,比對小型模型的性能改善更大。

顯然,大型模型比小型模型更善於從上下文範例中學習。

指令調優模型如何?

當前,指令調優是提高模型性能比較流行的一種方法。

然而,由於該過程使用自然語言標籤,一個懸而未決的問題是,它是否提高了學習輸入-標籤映射的能力,或者它是否加強了識別和應用語義先驗知識的能力。

這兩者都將導致標准上下文任務性能的提高。

研究人員繼續通過與前面相同的兩個設置來研究這個問題,只是這一次將重點放在比較標准語言模型(特別是 PaLM)和它們的指令調優變體(Flan-PaLM)上。

首先,當使用語義不相關的標籤時,Flan-PalM比PalM性能更好。

這種效應在小型模型中非常顯著,因爲Flan-PalM-8B的性能比PaLM-8B高9.6% ,幾乎趕上了PaLM-62B。

這種趨勢表明,指令調優加強了學習輸入標籤映射的能力,但這並不是令人驚訝的發現。

更有趣的是,研究者還發現Flan-PalM在遵循翻轉標籤上比PalM更差,這意味着指令調優模型無法覆蓋它們的先驗知識。

在100%翻轉標籤的情況下,Flan-PaLM模型無法做到隨機猜測,但是在相同的設置下,沒有進行指令調優的PaLM模型可以達到31%的准確率

這些結果表明,指令調優必須增加模型在語義先驗可用時的依賴程度。

結合前面的研究結果,研究者得出結論:雖然指令調優提高了學習輸入-標籤映射的能力,但它更強化了語義先驗知識的使用。

谷歌這篇論文強調了語言模型的ICL行爲如何根據其參數而改變,並且更大的語言模型具有將輸入映射到許多類型的標籤的湧現能力。

這是一種推理形式,其中輸入-標籤映射可以潛在地學習任意符號。

未來,更進一步的研究可以幫助人們去了解爲什么這些現象會與模型參數相關。

$谷歌-C(NASDAQ|GOOG)$$谷歌-A(NASDAQ|GOOGL)$$微軟(NASDAQ|MSFT)$#AI之战愈演愈烈,微軟、谷歌財報有哪些看點?#

本文作者可以追加內容哦 !

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播信息之目的,不構成任何投資建議,如有侵權行為,請第一時間聯絡我們修改或刪除,多謝。

標題:AI“黑箱”被打开?谷歌找到大模型能力湧現機制

地址:https://www.breakthing.com/post/60006.html