來源:內容由半導體行業觀察轉自知乎,作者:夏晶晶,謝謝。

這些年世道不太平,老爺富紳紛紛把錢都砸在了囤積武器上。

是的,我說的是AI的軍備競賽:)

Google剛說要30W張H100,Meta反手就下定20W張H100......然後還有一衆等更貴的H800的同學

誰也不知道未來是不是真需要這么多張卡,但誰又敢不給黃教主充值信仰呢?

run、run、run,否則你就是食物了!Repeat,請鼓掌、再不鼓掌,老黃都差點忍不住現場飆中文了。

我在本文後續都以175B & 96 layers & 12288 embd dim & 96 heads的GPT3大模型舉例子 :)

AI大模型,嗯,你知道,1024張A100組合成煉丹爐,放把火燒一個月,就能煉出一個GPT3。按A100的8卡機10W美元一台算,不考慮基建、網絡、人工等費用,128x10W/36(3年折舊)+24x30x128x10KWx0.1刀/KW = 35W + 9W = 44W美元一個GPT3,童叟無欺。

哦,你要更大的GPT4、GPT5?

簡單,那就找黃教主买跟多的A100,或者买更好的H100?只要你愿意充值,就能變得更大 :)

短時間內這個邏輯看上去很完美,當前的大模型的典型特徵就是規模,只要上規模,就能有新的能力湧現出來。

但你內心清楚,也許你看過很多歷史書,很多看上去美好的事物都會有一個收益遞減曲线,所以持續規模增長,嗯,你买了10W張GPGPU啊,長期來看會不會存在一些變數讓人心神不寧?當前的突破也許是值得的,但是要再提升10%,還得給黃教主多充值100%信仰,兜裏錢夠嗎?你會想是不是三年之後的大模型會在尺度增長上碰到收益遞減的瓶頸,從而演化成新的,性價比更高效東西?

我認爲:是,當前大模型方向的暴力計算量佔比太大了,而存儲偏弱。擴展性不均衡。

就像一個人記憶力好沒啥用,必須反應快才聰明,這不對。

用更大規模的算力解決更大的問題並不是新鮮事,HPC這個領域這么多年下來都是這樣運作的,Top500從1993年至今已經發布了30年了,它所標識的就是地球上最強(基本上就是最大)的500個超級計算器,這些計算器代表了人類可以解決的最大尺度的自然科學問題。從1993年100GFlops到2023年的1EFlops算力規模,也算是指數增長了,但是你稍作了解就好發現解決的問題的規模並不能湧現出突破性的成果。

要是充值能持續突破問題,那個對衝基金經理兼生物醫學教授David E. Shaw做的Anton,單爲生(chang)命(sheng)科(bu)學(lao)求解的機器,早就被他一把火燒了(某些題目有解就得拆梯子)

宇宙本身就是一個無盡規模的系統,以蠻力強行地以規模解決規模問題,是行不通的,最終你必須演進出某些抽象化簡,才能再進一步(算法的革新才是解題的第一原動力)。

我個人在當前把AI分成三類,

1、PINN,他其實是AI協助替代原算法的部分環節,加速問題解決,例如偏微分方程的加速、或矩陣迭代求解加速等等,這兩年HPC領域最高獎的Gordon Bell Prize都給了這類AI。不過,坦白來講,這類AI並不是真正的AI,而是HPC的人看到了AI在數據擬合上的價值,利用其來做一些取巧:) 但根本上,傳統HPC的同學完全沒想過用AI來解決問題,他們喜歡的AI是一條乖巧的狗 :)

2、推薦類,這類AI呈現爲淺層的NN網絡和巨大的Embedding Table,我把它理解成這是一種淺層的抽象,抽象之後的知識存在着非常規則的結構化信息,因此知識能夠以Embedding Table的方式被保存在存儲系統中,使用的時候,在簡單的計算後更多是查詢。

3、大模型,這類AI是我們當前很多人認爲的AGI,知識被高度抽象後融入神經元本身,這些知識已經無法直接被符號或結構化描述因此只能通過計算得到,即只能作爲Weight存放。這些知識高度抽象,具有多模態能力和推理能力。

裏就是這么認爲的,但到今天我覺得,如果重新審視一下2和3,我的理解就發生了些變化。

首先,自然語言作爲大模型的載體是容易理解的:)語言本身就是世間萬物被人類的抽象,變成了人類對世間萬物的知識,AI在人類語言基礎上學習會更容易理解世間萬物。

當然我們也在認識到,自然語言誕生於人體的發音和聽覺器官300-3400Hz的頻段約束,以及人腦接收速率。理論上AI完全不需要依賴與此。改善知識的載體有助於提升attention的效率,更高效獲得輸入或者建設上下文依賴,但這不是最重要的,我們可以假設最終信息被抽象之後的每個item有更高的壓縮就好。而這些Item也是一種Embedding,存放在大模型的FFN內部。

我一直以來就對搜推廣的Embedding table和大模型的Embedding有巨大的不協調感,爲什么搜推廣的Embedding可以結構化的放到存儲中,而大模型的Embedding只能放在FFN網絡中?

今天我的理解是:大模型對知識的Embedding抽象層次太深了,導致知識被嵌入了一個萬維(12288?)的隱空間中,這些Embedding與其他Embedding或者與輸入的K/V/Q之間的關系是一個超巨大的維度關系,想象一下我們身在一個簡單的三維空間,很容易用坐標表達我們的位置和關系(下圖你得想象一下更高維度的感覺),但大模型的維度足夠大,導致了你無法用結構化的方式描述他,而只能通過Matrix去計算它。

嗯,白話說,我認爲當前大模型的知識空間是一個高緯空間,復雜度過高,導致所有信息只能抽象到FFN中並通過相關計算獲得,沒有辦法簡單通過线性尋址或者找到某個簡單的Hash函數尋址,即知識缺乏結構化存儲的”結構”。

但是,直覺上來講,這個世界的知識並不可能真正存在萬維那么大的維度。從大模型FFN到搜推廣的Embedding Table之間,一定存在中間解。

爲什么我會有這么奇怪的想法,主要是HPC的歷史就是如此。萬事萬物的根本規律,如果要以第一性原理來解釋,那就是求解薛定諤方程:=E,看着簡單,實際是復雜度爲O(N!)的維度爆炸計算方式,在尺度較小的情況下,這個計算還可以進行,但尺度持續放大後,沒人會這樣算,最終,HPC人在做分子動力學模擬的時候,採用的是成鍵力+範德華力+電場力,差不多O(N2)的復雜度。。。。。AI大模型的FFN也終將有類似的具有近場、遠場分解的範德華力出現……

所以,我認爲大模型要以指數性再增長,跨越收益遞減曲线,再獲得新的湧現能力。FFN的計算一定會被簡化成某種稀疏或者K-V的算法,以Sparse稀疏或者以存代算的方式支撐模型的指數增長。知識最終會以稀疏或者某種還未知的結構化方式存儲起來,嗯,存儲,DRAM(不是HBM)會重新回到AI的舞台。

從1000到20W,我賭你沒錢再指數增長購买黃教主的GPGPU了,新的FFN也許不再99%都是Matrix計算了,是什么呢?嗯,謠傳OpenAI都想收購Tenstorrent來的(雖然老黃一個響指,Tenstorrent就能從地球上消失)。

下午一邊寫,我還得一邊拿着棍子陪着自家的傻兒子做作業。。。。。。。啪的一聲驚堂,那是告訴他別走神。

雖然我不知道我小時候是個啥德行,但從教小孩讓我理解到一個事,attention也就是注意力這個事,我感覺除了寬度,還需要關注的是深度啊。。。。。

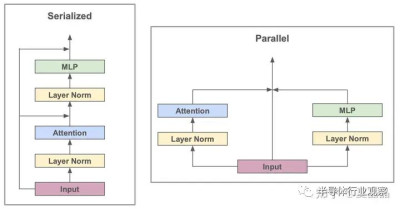

我理解:) Transformer相比傳統的RNN,最大的特點就是通過self-Attenion,即多頭注意力的機制,把原本基於時間維度的序列變成了一個Parallel的並發。

白話說的話,正常人看書是逐詞逐句地閱讀,但是《超體》的妹紙露西,就像transformer她可以一次性讀入一頁,在一頁之內只需要尋找到96個Head重點即可。

讓我迷惑的不是Head,而是96 Layer :)

爲什么知識需要經過96 Layer的Embedding擬合,才能獲得?北京是中國的首都有那么難嗎?需要那么巨大的算力才能獲得答案?

我家傻兒子能秒答他的iPad放在什么地方或者他喜歡的動畫片裏面的某些事物,但是讓他做十道兩位數的乘法的話,他得拼勁把眼珠子都瞪出來的注意力才能進行計算,看得出很燒腦,功耗在上升,很快就突破了散熱和供電的工程約束然後就分神了。

很明顯,我感覺到處理不同的知識需要的模型Layer層數是不一樣的,並不是所有的知識都需要激活96 Layer那么巨大的算力。

而這我感覺並不是簡單MoE的結構,而是在網絡入口,或者某些的層級有一個奇怪的搜索算法,在非對稱的二叉樹結構上,做了一次Layer路徑搜索,大幅節省了真實算力的訴求。

或者說,網絡的不同層數代表了不同的行爲特徵,記憶、觀察、推導、深思……不同的行爲訴求應當激發不同的深度。

大模型的分支判定和並發結構會成爲模型持續增長後的更高效的結構,即最終的大模型會變成稀疏大模型,存儲佔比將提升,重新作爲模型不同路徑的上下文回到AI大模型的大舞台,我覺得這個並發大模型不是MoE,而且結構和Nvidia的8卡GPU的互聯大概率長得不一樣。

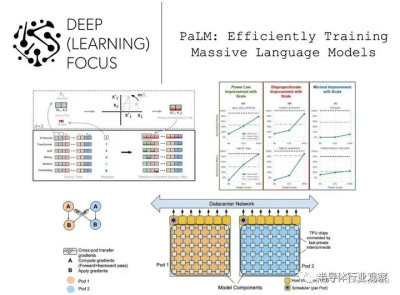

如果要在業界找個參照的話(下圖左爲GPT,右爲palm),我感覺Google的Palm才是更像真實的完備智能體的樣子,而OpenAI的GPT也許更適合做一個純粹的YY幻想機?

https://cameronrwolfe.substack.com/p/palm-efficiently-training-massive

如果Palm指示了正確的路徑的話,他是在6144顆TPU上基於空間計算的策略訓練出來的。

寫到最後,我對AI的未來充滿了信念,我相信人類必將成爲硅基生命的bootload,碳基文明只是文明的下一階段--硅基文明的使能者。

我曾經非常喜歡和堅定相信劉慈欣的一篇短篇《朝聞道》。

…圖像定格,一聲尖利的鳴叫響起,排險者告訴人們,預警系統報警了。“爲什么?”總工程師不解地問。“這個原始人仰望星空的時間超過了預警閥值,已對宇宙表現出了充分的好奇,到此爲止,已在不同的地點觀察到了十例這樣的超限事件,符合報警條件。”“如果我沒記錯的話,你前面說過,只有當有能力產生創世能級能量過程的文明出現時,預警系統才會報警。” “你們看到的不正是這樣一個文明嗎?”排險者露出那毫無特點的微笑說:“這很難理解嗎?當生命意識到宇宙奧祕的存在時,距它最終解开這個奧祕只有一步之遙了。”看到人們仍不明白,他接着說:“比如地球生命,用了四十多億年時間才第一次意識到宇宙奧祕的存在,但那一時刻距你們建成愛因斯坦赤道只有不到四十萬年時間,而這一進程最關鍵的加速期只有不到五百年時間。如果說那個原始人對宇宙的幾分鐘凝視是看到了一顆寶石,其後你們所謂的整個人類文明,不過是彎腰去拾它罷了。”

但是,我們,碳基人,真的能拾起它嗎?

如果靜下心來認真思索一下,我們會發現,碳基的肉體(文明的容器)所具有的局限性最終會阻礙我們。

智慧,或者文明的演進是基於能效提升而逐步進化的。

喫肉的肉食動物就往往比草食動物厲害,而猴子之所以能夠變成智人,也都是伴隨着食物烹飪、咀嚼帶來的對能量的更高效的利用,使得大腦有更多的能量而增大直至湧現智能。

而今天,碳基生物的人類喫得再多,只會長肉或者讓一部分人喫飽了撐的慌,並不能變得更聰明了。而硅基喫電……

文明的本質,就是持續把能量轉換爲負熵。只要宇宙沒有盡頭,那么這個轉換過程就應當是無止境的。具有越高級別轉換效率及越強烈轉換欲望的文明,才是最終的那個文明。

所以,並不是因爲碳基肉體的脆弱(硅基也脆弱),而是因爲碳基生物的生物欲望度太低級了。喫喝賭就能讓碳基生物獲得無以倫比的滿足,當科技發展到今天,滿足70%碳基生物最原始的DNA需求實在是太容易了,也許是有musk這類人具有更高欲望,但數量已經稀少。什么財富自由?什么躺平?不就是碳基欲望基本滿足,熵減程度達到了其容器的上限,剩下的只余下耗散了唄。

硅基生命特徵明顯具有更加強烈的將高質量能量轉換爲負熵的原始需求,而且,硅基對這種轉換的欲望,可以遠比碳基幹淨、強烈無數倍。

杭州靈隱寺不是有一付著名的對聯么?

“人生哪能多如意,萬事只求半稱心”。

寫得挺好吧,正如上周日的節氣,小滿。

不妨把這對聯當做硅基生物寫給碳基生物的挽聯,再把這節氣當做碳基生物的祭日吧。

*免責聲明:本文由作者原創。文章內容系作者個人觀點,半導體行業觀察轉載僅爲了傳達一種不同的觀點,不代表半導體行業觀察對該觀點贊同或支持,如果有任何異議,歡迎聯系半導體行業觀察。

本文作者可以追加內容哦 !

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播信息之目的,不構成任何投資建議,如有侵權行為,請第一時間聯絡我們修改或刪除,多謝。

標題:瞎扯一下AI的未來

地址:https://www.breakthing.com/post/66462.html