【EV視界報道】如今在國內,新能源汽車的發展已經逐漸的進入了下半場,而進入這個下半場的“門票”,莫過於自動駕駛的能力了。

在我們看來,自從高級別的自動駕駛能力开始被量產,主機廠在這方面的投入也是不遺余力,力爭成爲行業的翹楚。但這個領域不同於傳統造車,這裏面的“玩家”已經不再局限於傳統主機廠,軟件公司的加入,也帶動了整個行業的快速發展,讓國內的自動駕駛研發能力成爲了具有挑战全球行業的勇氣,百度就是其中之一。

作爲最早參與自動駕駛研發的企業,百度早在2011年就提出了一件名爲“一種數字地圖生成裝置及方法”的發明專利。自這件用以優化地圖導航底層技術的專利开始,此後的時光中,10數件地圖導航與汽車駕駛地理坐標相關發明專利相繼湧現。而這個時期可被視爲百度自動駕駛技術的萌芽期。到了2013年世界互聯網大會烏鎮峰會上,百度展示了自己改造的首輛自動駕駛汽車,而之後的2015年,百度用一台寶馬3系改裝車完成了國內無人車首秀,並且從北京新高速到五環進行了最高速度達100公裏/小時的自動駕駛演示。

所以有了前端的鋪墊,在國內自動駕駛的領域中,百度通過不斷地研發與推廣,早早的在自動駕駛行業中佔據了“領先”位置,因此就有了足夠的底氣與信心,並向行業證明了自身的技術實力,近日舉辦的百度Apollo Day就是很好的例子。

對於自動駕駛來說,相比較在高速路段的駕駛,在城市中的運用是最爲考驗技術的重要難關。一般來講,城市道路錯綜復雜,你永遠不知道什么時候會有電瓶車橫穿馬路;什么時候會有行人突然出現;什么時候會有慢行車擋路;什么時候會有其他車輛變道加塞。這種需要依靠自身經驗,無固定性的行駛場景,在自動駕駛領域被稱之爲Corner Case,也就是復雜場景,比如當你駕車正要變道的時候,突然有車輛要從旁邊“加塞兒”進來,而你會將如何處理?是退回原位?還是繼續變道?諸如此類無法確定走向的問題,都可以被稱爲復雜問題。目前如果要在城市道路中开啓自動駕駛的話,90%面對的是常規問題,而剩下的10%就是復雜場景了,這也就是自動駕駛最爲關鍵的所在。

相比較我們常見的自動駕駛能力,百度Apollo安全性最大的優勢就在故障處理策略上,在面對自動駕駛中的不同場景,通過對仿真系統的完善,百度Apollo不僅具備即時處理安全問題的能力,還能不斷對其進行雲端調整。

這種調整是百度Apollo通過把"不確定因素"放入雲端,仿真系統對其進行模擬判斷,判斷標准有兩個——“知道不知道”與“安全不安全”,在雲端不斷模擬之下,當路上遇到相同情況的時候,這些模擬場景均會被調用,這種體系之下,安全性就會被逐步加強。

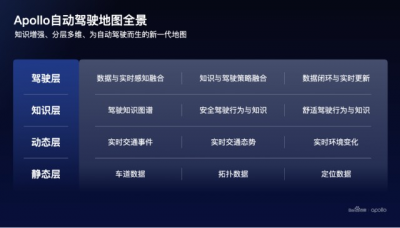

另外,在構成自動駕駛的基礎技術方面,包括自動駕駛地圖、多模態感知、預測決策、自適應規劃控制等四個方面,它們是構成百度自動駕駛技術的基石,也是本次百度Apollo Day上的重點。

高精地圖與大模型,雙管齊下的倍增器說到自動駕駛地圖,我們首先想到的莫過於高精地圖。但隨着行業的發展,越來越多的企業認爲高精地圖一定是過渡,雲端的結合也只是一個輔助,所以就有了" 重感知,輕地圖" 的認知。而作爲高精地圖提供商之一的百度確不這樣認爲,並公开表示,對於 L4級自動駕駛而言,要達到99.99%以上的成功率,地圖是不可或缺的底層能力,特別是在應對道路標識出現遮擋、污損、新舊重疊時,單靠實時感知是無法解決的。

不過,要想研發一套完整的高精地圖,需要的研發周期長、成本高昂,所以這不是一般的企業能夠承受的。因此,百度Apollo的自動駕駛地圖要完成“輕成本,重體驗”的目標。

首先在“輕成本”上,百度用自動化數據融合讓地圖的成本大大降低,這主要是通過對所有地圖數據的收集、小塊處理並進行幾何融合的方式,完成最終自動駕駛地圖的形成,百度克服了包括塊狀地圖融合的精度、場景化的關聯、重疊部分的融合效率等等難點,最終達成了“輕成本”目標。目前,在高精地圖層面,AI是降本增效的核心驅動,百度高精地圖構建自動化率已達到96%,大幅解決了應用成本高的問題。

而在“重體驗”上,百度Apollo主要是針對一些在實際場景中,包括多次變道、突發限速等情況都會讓乘客的體驗變差,這時候百度提出了“駕駛知識圖譜”,即基於百度地圖1200萬公裏的領先路網覆蓋範圍及海量時空數據,結合數億司機的駕駛知識沉澱,構建全路網級別的駕駛知識圖譜,而這個圖譜包括:行駛速度、變道時機、變道軌跡等等。這一層輸入,是自動駕駛由笨拙變得順滑的關鍵。如此讓系統學習人類司機經驗,用駕駛知識圖譜爲自動駕駛搭建進步的階梯。

那么,百度Apollo如何做到讓自動駕駛逐步學習的呢?這裏就要提到一個概念——大模型。

在自動駕駛發展過程中,多傳感器的融合是達成目標的必要條件,這其中算法成爲了整個系統的核心內容。在之前的百度Apollo自動駕駛感知1.0中,系統是以激光雷達爲主,加入環視、毫米波的後融合感知方案,後融合是以規則驅動的,若出現一些特殊情況(小動物、貨車外凸的貨物等),往往這種算法就會出現誤判,這肯定不符合自動駕駛的要求。而隨後出現的感知2.0是多模態、前融合、端到端的方案爲主;除此之外,補充以遠距離的視覺感知以及近距離的魚眼感知,而在這其中,大模型發揮的作用包括數據挖掘、數據標注等等。

百度Apollo的大模型技術能夠讓自動駕駛在短距離、中等距離與遠距離都能有不錯的表現。大模型算法主要有兩個方面的新內容,首先是有關新模型的判定,2D數據容易獲取,3D數據獲取相對困難。可以利用2D標注數據和3D標注數據,迭代自訓練的方法得到一個效果不錯的感知大模型,再利用大模型對數據進行3D的僞標注,讓大模型下沉到小模型,並且在實際場景中大型模來幫助小模型解決自動駕駛中的誤判,比如在道路上遇到對向灑水車正在灑水的情況,大模型會判斷對向的灑水車,從而幫助車型判斷出“灑出的水”這個小模型,減少對“水”的誤判情況。隨着各個大模型的疊加,這種訓練會越來越簡單,越來越快,自動駕駛算法在實時判斷也會更准確。

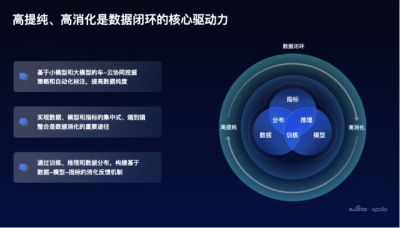

另外,在自動駕駛的過程中,車輛會遇到各種意想不到的場景,比如 羊群過馬路。解決罕見、長尾場景,是數據閉環的價值。與感知、規控、決策的技術棧相比,大規模數據閉環的建設是行業裏的嶄新命題。

數據閉環的前半是大量數據帶來的存儲和標注的壓力,後半是大規模數據用於訓練的計算量需求暴增。百度Apollo設計的數據閉環,核心是解決「高提純、高消化」的問題。

在數據提純上,百度的方案是利用車端小模型+雲端大模型,做高效的挖掘和自動化標注;數據消化架構,實現自動化訓練,具備聯合優化和數據分布理解的能力,利用高純度的數據進一步提升自動駕駛系統的整體智能水平。除此之外,訓練、推理以及數據分布在數據消化過程中,形成:數據-模型-指標的消化反饋機制,進一步提升數據消化的整體效率和效果。

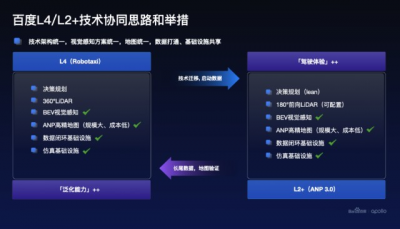

百度的自動駕駛路线爲 L4/L2+ 技術共生路线,是行業第一家同時具備L4 Robotaxi技術和量產L2+輔助駕駛方案的公司,百度自動駕駛技術專家王亮認爲,百度賦能汽車智能化的信心和底氣源於十年自動駕駛技術沉澱。目前,技術棧層面已實現L4與L2+智駕產品視覺感知方案統一、技術架構統一、地圖統一、數據打通及基礎設施共享。L4將持續爲L2+智駕產品提供先進的技術遷移,L2數據反哺也將助力L4泛化能力提升。同時,王亮也強調高精地圖是保障L2+城市級智駕產品高安全、體驗好的必要條件。

除此之外,在軟件上的建樹,硬件方面也成爲了近期自動駕駛行業的另一個焦點。衆所周知,隨着世界風雲的改變,芯片已經成爲決定行業生存的關鍵之一。在百度Apollo Day技術开放日上,昆侖芯科技CEO歐陽劍透露,百度自研AI芯片昆侖芯2代已完成無人駕駛場景端到端性能適配,這也將持續夯實百度Apollo軟硬一體優勢。

其實,百度自研的昆侖芯片已經量產了兩代,實現數萬片的商業化部署。第三、第四代產品都在研發中,三代芯片預計明年量產,四代芯片後年量產。

昆侖芯片採用的XPU-R架構,通過7nm先進工藝,能夠達到128TFLOPS FP16的強大算力,完全滿足自動駕駛的需求,除此之外,昆侖芯二代還擁有32GB的高速閃存以及512GB/s的內存帶寬,並且支持虛擬化,芯片間互聯和視頻編解碼,是非常完備的AI芯片。而對於行業來說,昆侖芯片也具有着以下幾點優勢:首先昆侖二代AI芯片已經在互聯網,工業質檢、智慧交通智慧金融等場景均有實際部署,也證明了該芯片的可行性;其二是昆侖芯片已與多款通用處理器、操作系統、AI框架完成端到端的適配;其三昆侖芯片專門爲开發者提供了全方位的軟件工具包,讓大家都能更簡單的對昆侖芯片系統進行獨立個性化的开發與定制。

目前昆侖芯二代已經在百度的Robotaxi系統上進行了完整的適配,並开始道路測試。

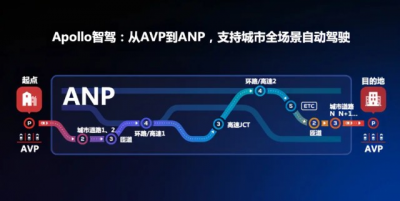

告別堆料,ANP3.0讓自動駕駛“眼光發亮”在本次百度Apollo Day技術开放日,重頭戲莫過於百度ANP3.0自動駕駛方案了,它將在國內率先支持復雜城市道路場景,並且銜接融通高速和泊車場景。

相比於某些品牌的“堆料”做法,硬件上百度選用了包括500+ TOPS AI算力得到Nvidia Drive Orin-X,max視距~400m的環視8MP攝像頭、1,536,000 points/s的SOTA半固態激光雷達。在系統的構成上,ANP3.0將以視覺方案爲主,將激光雷達作爲安全冗余來做支持。

ANP3.0所搭載的第二代純視覺感知系統Apollo Lite++通過Transformer把前視特徵轉到BEV,在特徵層面對相機觀測進行前融合後,直接輸出三維感知結果,並融合時序特徵實現運動估計Learning化。

可以說,百度視覺感知方案Apollo Lite是世界唯三、中國唯一支持城市道路的純視覺,自動駕駛的感知系統;LiDAR則是由百度Apollo十年深耕,算法理解、實踐經驗和數據儲備全面領先,成熟可靠的激光雷達方案。在兩種系統的加持下,百度自稱是“國內唯一真‘冗余’的環境感知系統”。通過Transformer把前視特徵轉到BEV,在特徵層面對相機觀測進行前融合後,直接輸出三維感知結果,並融合時序特徵實現運動估計Learning化。

模型設計層面,基於transformer結構,實現時空特徵融合。之後,在空間融合階段將位置編碼變換從全局BEV空間轉換到局部相機坐標系,消除相機內外參差異帶來的差異。時序上盡可能多的融合主車運動與多幀信息,提升障礙物檢測穩定性。同時基於時序特徵,障礙物的速度、意圖、未來軌跡預測等關鍵信息都可以進行端到端的輸出。另外,對後處理的多相機融合依賴更低,算力需求更輕,泛化性更好。

目前ANP3.0已進入北上廣深多地泛化測試階段,將在2023年夏天隨着第一個客戶車型上市與大家見面。

可以說,百度Apollo Day技術开放日首次對外全面展示了其智能駕駛的技術路线,並讓我們了解到了百度在自動駕駛系統感知、預測決策、規劃控制,以及數據閉環、地圖、算力等全鏈條技術方案,更深層次的也讓我們真正了解到了未來的無人駕駛會是什么樣子。相信,隨着技術的發展,中國無人駕駛的商業化進程正逐步從點連成线,特別是在消費端,中國消費者對自動駕駛的接受度也越來越高,而這對於我們向發達國家“彎道超車”起着至關重要的進步。 因此,百度能否在這“下半場”發展中再次引領行業,未來的發展又將發生怎樣的變革?我們拭目以待。

本文作者可以追加內容哦 !

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播信息之目的,不構成任何投資建議,如有侵權行為,請第一時間聯絡我們修改或刪除,多謝。

標題:關於自動駕駛,百度ApolloDay上都說了啥?

地址:https://www.breakthing.com/post/35452.html