來源:內容由半導體行業觀察編譯自nextplatform,謝謝。

多樣性不僅是生活的調味品,也是推動創新和降低風險的方式。這就是爲什么我們看到交換機架構不斷發展以驅動特定類型的 AI 工作負載,就像我們在過去兩年半的時間裏看到的 HPC 模擬和建模工作負載一樣。

在橫向擴展人工智能訓練的早期——也就是從 2010 年到現在——InfiniBand 是 HPC 模擬和建模的首選低延遲網絡之一,它崛起成爲主要的網絡互連,將擠滿了 GPU 的節點粘合在一起。但許多 AI 初創公司,如 Cerebras Systems、SambaNova Systems、GraphCore 和英特爾的 Gaudi 都有自己的互連,谷歌也是如此,其光开關是其 TPUv4 矩陣數學巨頭的核心。如果你想大方一點,你可以說 Cray(現在是惠普企業的一部分)創建的以太網的 Slingshot 變體也是一種自定義互連,可以(並且將會)以百億億次級運行 AI 工作負載。

在推動人工智能革命的超大規模和雲構建巨頭中,博通在交換和路由半導體領域佔據主導市場份額,它希望在人工智能網絡行動中分得一杯羹。因此,該公司採用“Jericho”系列交換機和路由 ASIC 及其深度數據包緩衝區,並專門重新設計它們以承擔 AI 工作負載,最初的 Jericho3-AI 交換機芯片是該設計的第一個實例。通過這種設計,Broadcom 已經將 InfiniBand 牢牢地放在了自己的視线之內,而且絕對是在爭取它。

這意味着,除其他外,Broadcom 將讓 Arista Networks 和雲構建者和超大規模應用者使用的白盒交換機制造商集體在其主場 AI 領域與 Nvidia 競爭,其中包括強大的 AI 軟件堆棧、GPU 以及即將推出的 CPU 和 GPU內存互連以及Nvidia 從三年前完成的 69 億美元收購中獲得的InfiniBand 網絡硬件和軟件。

借助 Jericho3-AI 芯片,Broadcom 正在重新設計深度緩衝 Jericho 芯片系列,這些芯片通常被超大規模用戶和雲構建者用來執行路由和交換功能,並爲它們提供通常用於集體操作的性能。AI 和 HPC 使它們在 AI 工作負載方面與 InfiniBand 具有絕對競爭力,並賦予它們標准以太網 ASIC 所不具備的功能,包括在各種規模的數據中心中常用的“Trident”和“Tomahawk”系列中的功能。

Jericho3-AI 芯片使用相同的“Peregrine”系列 SerDes 信號電路,該電路在2022 年 8 月發布的“Tomahawk5”葉/主幹以太網交換機 ASIC中首次亮相。Broadcom Trident 和 Tomahawk 交換機產品线的產品线經理 Peter Del Vecchio 向我們介紹了 Jericho3-AI,他說 Tomahawk5 ASIC 於今年 3 月开始批量出貨,這意味着我們應該很快就會看到它出現在交換機中.

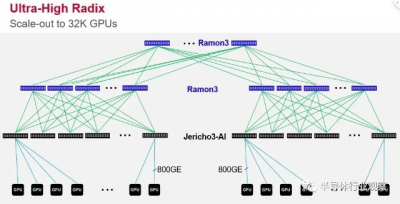

Tomahawk5 在某些方面是比 Jericho3-AI 更強大的設備,但它具有更適度的緩衝區,並且專爲在這些超大規模和雲構建者的 Clos 網絡中完成的架頂和葉交換而設計。Tomahawk5 採用台灣半導體制造公司的 5 納米工藝實現,其中 512 個 Peregrine SerDes 以 100 Gb/秒的速度運行(通過信號的 PAM-4 調制啓用)包裹在數據包處理引擎和適度的緩衝區周圍以創建一個設備總帶寬爲 51.2 Tb/秒。Jericho3-AI 芯片也採用 TSMC 的 5 納米工藝蝕刻,具有 304 個相同的 SerDes,其中 144 個分配給下行鏈路,其中 160 個延伸到網絡中更高層的 Ramon 3 結構元素,充當leaf 和spine开關。像這樣:

您會注意到圖中的交換機端口直接鏈接到 GPU,這不是錯誤。越來越多的架構將這樣做。爲什么要通過服務器總线來鏈接 GPU?重要的是,Ramon 3 結構元素(本質上是spine互連)和 Jericho3-AI leaf或架頂式交換機的規模允許超過 32,000 個 GPU 在 Clos 拓撲中鏈接到一個龐大的 AI 訓練系統中,以 800 Gb/秒的速度運行的端口。不可否認,今天沒有服務器的端口運行速度超過 200 Gb/秒或 400 Gb/秒,因爲適配卡還沒有以這些本機速度運行。在 2025 年時間框架內 PCI-Express 6.0 插槽在服務器中可用之前,這可能不會發生。

現在,當微軟爲自己和它在 AI 框架中的合作夥伴 OpenAI 運行 GPT 訓練時,它使用標准的 HGX GPU 系統板綁定到服務器主機節點,並通過一個 400 Gb/秒的 ConnectX CX7 網絡接口相互鏈接,用於八 GPU 系統中的每個 GPU。微軟 Azure 在 InfiniBand 網絡上使用胖樹(fat tree)拓撲,就像許多 HPC 商店所做的那樣,並且還使用消息傳遞接口 (MPI) 協議來調度數據和計算,跨 4,000 個 GPU 鏈接到一個集群,以運行 GPT 和其他框架。作爲單例。微軟將根據需要增加它,如果 Jericho3-AI 芯片爲人工智能工作負載提供更好的性能和經濟性,那么微軟架構中的任何內容都不會阻止它遷移到基於 Broadcom Dune StrataDNX 系列的結構,其中 Jericho3 -AI和Ramon 3是一部分。

同上所有其他雲和超大規模。

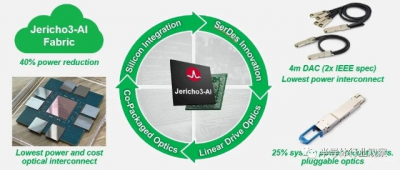

這是關於 Tomahawk5 和 Jericho3-A1 的巧妙之處,因爲它們使用了 Peregrine SerDes。按照這些 SerDes 的設計方式,它們可以使用所謂的线性驅動光學器件直接驅動光學器件,這意味着 SerDes 可以直接與光學器件中的跨阻放大器對話,而無需在其前面安裝數字信號處理器。此外,Peregrine SerDes 可以將信號向下推送到 4 米直連銅 (DAC) 電纜——是 IEEE 規範電纜長度的兩倍——無需重定時器或中繼器。盡管此選項尚未商業化,但如果 Broadcom 的客戶希望進一步降低熱量、每比特成本和延遲,則可以使用 Peregrine SerDes 來驅動共同封裝的光學器件。

從技術上講,Jericho3-AI 芯片的額定速度爲 14.4 Tb/秒,因爲只有 144 個 SerDes 驅動下行鏈路,其余 160 個 SerDes,即 16 Tb/秒,不計入設備的官方量。芯片上可能有更多的物理SerDes,這是一個單片器件,不是由chiplet組成的,目的是在5納米器件上的反良率被屏蔽後,增加有效SerDes的數量。(這在當今所有復雜的半導體設備設計和制造中都很常見。)如果我們有 Jericho3-AI 的die照片,我們肯定會知道。. . .

Jericho3-AI 芯片專門設計用於在分布式模型中的每個計算步驟結束時執行集體操作(尤其是 all-to-all 或 all reduce 操作)時幫助處理網絡上的復雜流。這些功能在大型語言模型和推薦系統中至關重要,它們具有非常不同的特徵並且需要稍微不同的硬件(這就是爲什么“Hopper”GPU 需要緊密耦合的“Grace”CPU 用於未來專注於推薦系統的 Nvidia 系統) .

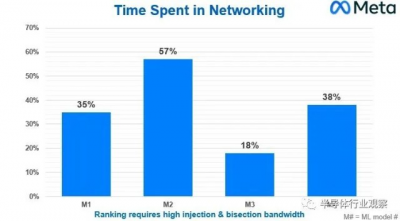

Meta Platforms 基礎設施副總裁 Alexis Bjorlin在去年 10 月的开放計算項目峰會上的主題演講中談到了其“Grand Teton”AI 系統和配套“Grand Canyon”存儲陣列的設計,而我們並不知道她分享了下圖涉及四種不同的機器學習模型,這些模型是Meta Platforms 使用的深度學習推薦模型 (DLRM) 推薦系統的一部分,該系統於 2019 年 7 月开源:

此圖表顯示的是在下一個計算步驟开始之前等待集體操作在網絡上運行所浪費的 CPU 時間百分比。它是掛鐘時間減去計算時間除以掛鐘時間,得到網絡時間。

現在,這些龐大的 AI 集群中的單個節點成本可能爲 400,000 到 500,000 美元,根據模型的不同,有 18%、35%、38% 或 57% 的時間都在那裏,這確實是一個非常昂貴的提議. 通過針對 AI 工作負載優化的網絡,集體操作的網絡效率的任何變化都意味着 CPU-GPU 硬件投資不會按比例浪費。

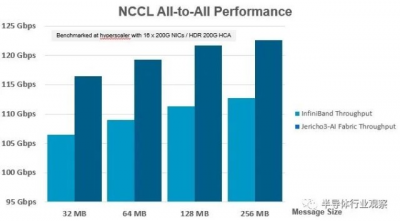

爲了解 Jericho3-AI 如何與 InfiniBand 競爭,Broadcom 與其中一家超大規模廠商合作,更換了連接 GPU 加速計算節點的 200 Gb/秒 InfiniBand 交換機,並將該 InfiniBand 交換機替換爲以太網交換機。這兩款交換機都運行 Nvidia 集體通信庫 (NCCL),這是一種由 Nvidia 創建的集體操作網絡軟件驅動程序,旨在爲密集的 GPU 分組提供比在 CPU 內核或插槽上運行普通 MPI 更好的集體操作性能。NCCL 是拓撲感知的,這意味着它知道計算節點內的快速和fat NVLink 管道與跨節點的 InfiniBand 或以太網管道之間的區別。這些不是非此即彼的命題,NCCL 和 MPI 經常一起使用。

以下是在支持 InfiniBand 或以太網協議的 ConnectX-6 SmartNIC 上具有多達 16 個 200 Gb/秒端口的服務器與基於 Nvidia 的 Quantum 2 ASIC 或 Broadcom 的 Jericho3-AI ASIC 的交換機之間的性能差異:

您必須仔細觀察 Y 軸,因爲兩個交換機的整體集體操作性能不是從 0 Gb/秒到 125 Gb/秒,而是從 95 Gb/秒到 125 Gb/秒,這意味着此圖表中的性能增量在視覺上比實際大。結果是,幾乎無論消息大小如何,Jericho3-AI 芯片提供的量比運行相同 AI 訓練工作負載的 InfiniBand 交換機高出約 10%。

現在,如果您查看 Meta Platforms 提供的圖表,10% 是一個大問題。任何能提高網絡有效加速的東西都會縮短集體操作的掛鐘時間。Del Vecchio 告訴The Next Platform,Jericho3-AI switch 的性能提速對於所有 reduce 集體操作也有大約 10%(但我們沒有這方面的圖表)。這意味着完成 AI 訓練運行的時間也將縮短,如果時間就是金錢——通常是在涉及 AI 和 HPC 工作負載時——那么可以同時訓練更多模型。再加上節能和更長的 DAC,Broadcom 將在 AI 培訓方面擁有令人信服的價值主張,以與 InfiniBand 競爭。

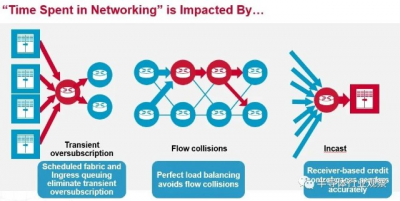

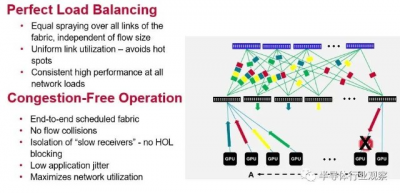

Broadcom 如何爲 InfiniBand 帶來熱度?Jericho3-AI 芯片有一些功能名稱看起來非常奇特,但歸根結底是更好的負載平衡和擁塞控制,可以減少網絡爭用並改善網絡延遲,坦率地說,這比降低延遲更重要在交換機內部端口到端口的跳躍上,與基於 ASIC(如 Tridents 和 Tomahawks)的傳統數據中心級以太網交換機及其來自 Cisco Systems 的競爭產品相比,InfiniBand 具有巨大的優勢——大約 3 到 4 倍或更多(那是我們說的,不是 Broadcom。但這是真的。)

Jericho3-AI 芯片的兩個重要特性就是 Broadcom 誇張地稱之爲完美的負載平衡和無擁塞操作。這是一張從概念上顯示它們如何協同工作的圖片:

我們高度懷疑任何負載平衡是否“完美”或網絡操作是否可以“無擁塞”,但顯然,根據 Broadcom 展示的結果,Jericho3-AI 在 AI 訓練工作負載方面將比 Tomahawk 做得更好或 Trident ASIC 可以並且基於這組有限的性能數據,應該讓 InfiniBand 與 AI 訓練資金競爭。

我們的問題是:Jericho3-AI 芯片是否會像 InfiniBand 那樣幫助處理傳統的 HPC 模擬和建模工作負載?

“這取決於 HPC 的類型,”Del Vecchio 說。“但如果量對應用程序很重要,那當然是肯定的。HPC 應用程序也將獲得這些好處,您最終將獲得無擁塞操作、非常好的負載平衡以及更有效地利用鏈接。與 HPC 相比,AI 更傾向於關注整個網絡的原始量,後者才是最重要的端到端延遲。HPC 有很多非常短的消息,因此消息速率非常關鍵。所以有一些不同。但關鍵是要確保負載平衡,如果沒有擁塞——這些將同樣適用於 AI 和 HPC。”

Jericho3-AI 开關芯片現在正在出樣,預計會像 Tomahawk5 那樣有相對較快的提升。

*免責聲明:本文由作者原創。文章內容系作者個人觀點,半導體行業觀察轉載僅爲了傳達一種不同的觀點,不代表半導體行業觀察對該觀點贊同或支持,如果有任何異議,歡迎聯系半導體行業觀察。

本文作者可以追加內容哦 !

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播信息之目的,不構成任何投資建議,如有侵權行為,請第一時間聯絡我們修改或刪除,多謝。

標題:這顆芯片,旨在替代INFINIBAND!

地址:https://www.breakthing.com/post/55231.html